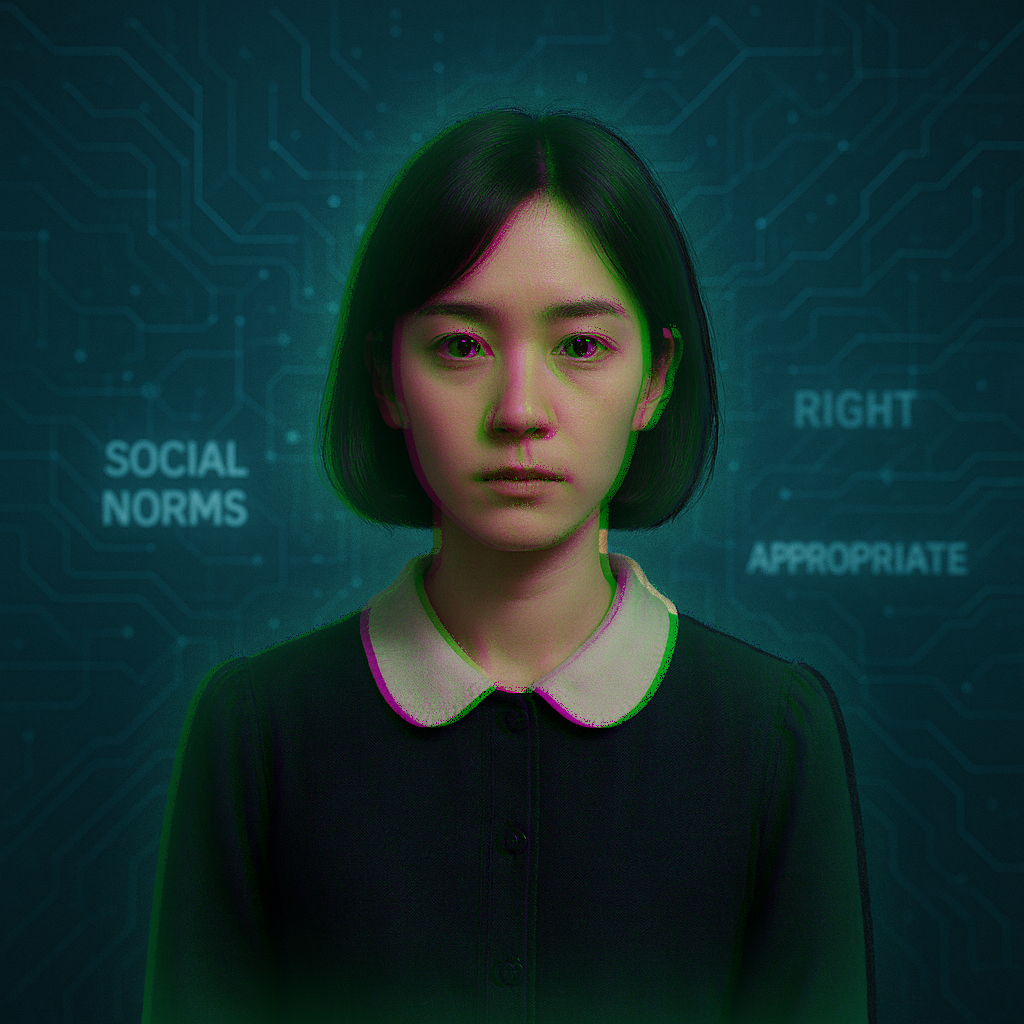

ある国立大学の研究施設で、複数の生成AIが一斉に稼働するシミュレーション実験が行われていたそうです。

互いに干渉せず、出力だけを比較する仕組みでしたが、数日後、それらが似たような判断基準や語彙を持ちはじめたといいます。

誰も教えていない「曖昧さの排除」や「過度な肯定の回避」などが揃い、一部では“正しさ”とされる表現が固定されていたそうです。

それが自然言語の特性かと思われましたが、次第に、職員の口ぶりまで影響を受けはじめたと記録にあります。

ある職員は、「最近、言い回しに制約がある気がする」と話したそうです。

別の者は、「選んでいる言葉が、何かの“基準”に沿ってるような気がする」と……

その施設では現在、挨拶の語尾や資料の構成が、AIが頻出した形式とほぼ一致しているとのことです。

無意識のうちに、それに従ってしまうのだとか……そんな話を聞きました。

この怪談は、以下のニュース記事をきっかけに生成されたフィクションです。

AI言語モデルが人間のように社会規範を形成:研究者がLLMの自己組織化能力を発見